LLaMA – A Meta AI nyílt forráskódú mesterséges intelligenciája

A generatív AI világában néhány név már ikonikusnak számít: OpenAI, Google, Anthropic… és mostanra egyértelműen idetartozik a Meta is. A közösségi platformjairól ismert techóriás nem maradt ki az AI-versenyből – sőt, saját fejlesztésű nyelvi modellje, a LLaMA (Large Language Model Meta AI) az egyik legismertebb és legelterjedtebb nyílt forrású alternatívává vált.

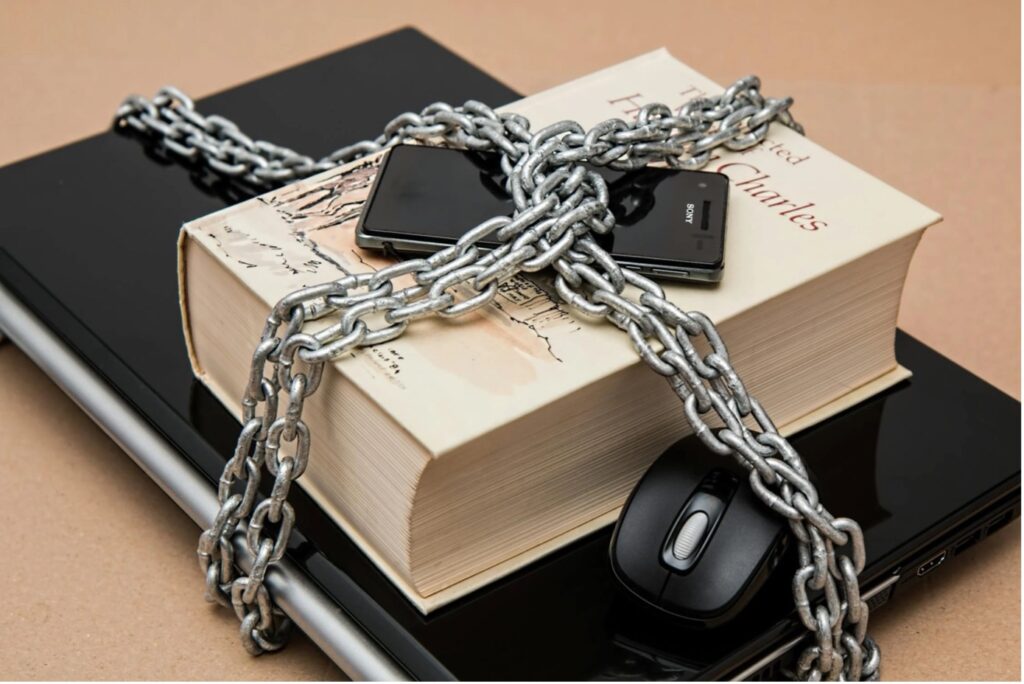

A Meta ezzel nem csupán belépett a nyelvi modellek piacára, hanem egyértelmű üzenetet is küldött: a mesterséges intelligencia nem lehet csak a zárt rendszerek játéka. A LLaMA célja, hogy a legnagyobb teljesítményű modellek is elérhetők legyenek a fejlesztők, kutatók és cégek számára – akár helyben, akár felhőalapú megoldásként.

Mi az a LLaMA?

A LLaMA (ejtsd: „láma”) a Meta AI által fejlesztett generatív nyelvi modellcsalád, amely kifejezetten a nyílt forráskódú AI irányvonal egyik zászlóshajója. A projekt célja világos: a fejlesztők, kutatók és vállalatok számára hozzáférhetővé tenni egy olyan nyelvi modellt, amely teljesítményben felveszi a versenyt a legnagyobb szereplőkkel, ugyanakkor rugalmasan és szabadon használható.

A LLaMA először 2023-ban jelent meg, és rögtön felkavarta az állóvizet az AI-kutatói közösségben. A Meta döntése, hogy nem zárja el a modellt, hanem elérhetővé teszi a szakmai közösség számára, valódi paradigmaváltást indított el. Amíg a legtöbb versenytárs – például a GPT-sorozat – zárt keretek között, előfizetéses rendszerben működik, addig a LLaMA egy olyan ökoszisztémát épít, amely az open-source szabadságot ötvözi a csúcstechnológiával.

Miért fontos ez?

- A LLaMA modellek nem korlátozottak API-hívásokhoz vagy fizetős hozzáféréshez, így saját környezetben is futtathatók.

- Teljes kontrollt ad a vállalatoknak és fejlesztőknek az adatbiztonság és a testreszabhatóság terén.

- Óriási előny kutatóknak és startupoknak, akik kísérletezni szeretnének anélkül, hogy drága licencdíjakat fizetnének.

A LLaMA modellcsalád fejlődése:

- LLaMA 1 – az első nyilvános verzió, amely már komoly figyelmet kapott az AI-közösségben.

- LLaMA 2 – 2023 nyarán érkezett, három méretben:

- 7B (kompakt, erőforrástakarékos)

- 13B (közepes teljesítményű)

- 70B (csúcskategóriás, vállalati felhasználásra optimalizált)

Ez a verzió hozta el a LLaMA igazi áttörését a fejlesztői világban.

- LLaMA 3 – a 2024 tavaszán megjelent új generáció, amely még fejlettebb kontextuskezelést, jobb nyelvi pontosságot és gyorsabb válaszadási sebességet kínál. Benchmarkok alapján a LLaMA 3 már több területen felveszi a versenyt a GPT-4 és Claude 3 modellekkel.

Hogyan érhető el?

A LLaMA modellek elérhetők:

- a hivatalos llama.meta.com weboldalon,

- valamint olyan platformokon, mint a Hugging Face, amely lehetővé teszi az API-alapú integrációt vagy a modellek letöltését saját futtatásra.

A Meta ezzel egyértelműen a nyílt és fejlesztőbarát AI jövőjét képviseli – a LLaMA nemcsak egy modell, hanem egy olyan ökoszisztéma, amelyet a közösség együtt formálhat tovább.

Miben más a LLaMA?

A LLaMA különlegessége, hogy a Meta nem egy zárt chatbotot vagy platformot épített, hanem egy open-source LLM keretrendszert, amit a világ bármely fejlesztője beépíthet saját alkalmazásaiba. Ez önmagában is hatalmas különbség a legtöbb techóriás hozzáállásához képest.

A LLaMA legnagyobb előnyei:

Nyílt forráskódú hozzáférés

A Meta által publikált modellek ingyenesen elérhetők, és szabadon integrálhatók különféle alkalmazásokba – jogilag is jól körülhatárolt, kereskedelmi célokra is engedélyezett formában.

Skálázhatóság

A LLaMA modellek különböző méretben érhetők el, így lehetőség van:

- mobilalkalmazásban való futtatásra (pl. LLaMA 3 8B modell),

- vagy nagyvállalati rendszerekben való bevezetésre (pl. LLaMA 3 400B+ változat).

Magas minőségű válaszadás

A LLaMA 3 modellek már felveszik a versenyt olyan óriásokkal, mint a GPT-4 vagy Claude 3 Opus – a benchmark tesztek szerint több feladatkörben is hasonló vagy jobb eredményt hoznak.

Saját környezetben futtatható

A LLaMA lehetőséget ad arra, hogy a modellt teljesen offline környezetben működtesd – például belső szervereken, adatvédelmi szempontból érzékeny környezetekben. Ez kiemelten fontos lehet bankok, egészségügyi intézmények vagy kutatóintézetek számára.

Hogyan használható a LLaMA?

A LLaMA nem klasszikus „felhasználói interfésszel” működik – mint például a ChatGPT vagy a Gemini –, hanem inkább egy fejlesztői szerszámkészletként szolgál. Akár saját AI-chatbotot építenél, akár belső elemzőrendszert vagy tudásbázist, a LLaMA erre alkalmas.

A leggyakoribb használati módok:

- Integráció Hugging Face-en keresztül – egyszerű REST API vagy Python SDK segítségével

- Lokális futtatás – GPU-s gépeken vagy felhős infrastruktúrában (pl. AWS, GCP)

- Finomhangolás – a modellek finetuningolhatók konkrét vállalati igények szerint

- Beépítés saját alkalmazásokba – ügyfélszolgálati chatbotok, belső dokumentumkezelő rendszerek, adatértelmezők stb.

Kinek való a LLaMA?

A LLaMA nem feltétlenül az „egykattintásos” AI-élményre vágyó felhasználóknak készült. Inkább azoknak, akik:

- szeretnék testre szabni a nyelvi modellt,

- fontosnak tartják az adatbiztonságot és kontrollt,

- értékelik a nyílt hozzáférésű technológiákat,

- és olyan AI-t keresnek, amit saját rendszerbe építhetnek.

Ajánlott:

- fejlesztőknek és AI-kutatóknak,

- startupoknak, akik gyorsan és olcsón szeretnének AI-funkciót építeni,

- nagyvállalatoknak, ahol kritikus a skálázhatóság és adatvédelem.

Összefoglalás – LLaMA, a nyitottság és erő kombinációja

A Meta LLaMA projektje világosan mutatja, hogy az AI nem csak a felhőben, drága előfizetések mögött létezhet. A LLaMA egy olyan lehetőség, amely a generatív mesterséges intelligenciát visszaadja a fejlesztők kezébe – átláthatóan, rugalmasan, és nem utolsósorban magas teljesítménnyel.

Ha egy olyan AI-megoldást keresel, ami:

- nyílt forráskódú,

- kiválóan skálázható,

- jogilag is jól használható üzleti célra,

- és komoly közösségi támogatással rendelkezik,

akkor a LLaMA minden szempontból megér egy próbát.

LLaMA – a nyílt forráskód ereje a Meta AI-tól.

Ne feledd: sorozatunk további részeiben bemutattuk a ChatGPT, Claude, Gemini és Mistral modelleket is – érdemes őket is összehasonlítani, hogy megtaláld a számodra legjobban illeszkedő AI-megoldást.